Sieć stała się częścią codziennego życia. Za jej pomocą kontaktujemy się ze sobą, pracujemy, robimy zakupy, czerpiemy informacje o otaczającym świecie, korzystamy z kultury i rozrywki. A przy okazji zostawiamy całą masę informacji o sobie: część sami – mniej lub bardziej świadomie – upubliczniamy, część przesyłamy innym lub zapisujemy w chmurze, a część wreszcie zostawiamy zupełnie mimowolnie – to tzw. metadane, czyli informacje, z kim się kontaktujemy, na jakie strony wchodzimy, z jakiego sprzętu korzystamy czy gdzie przebywamy. Wbrew pozorom – w sieci prawie nigdy nie jesteśmy anonimowi. Choćby dlatego, że informacje połączone ze sobą pozwalają nas zidentyfikować. A nawet ich ułamek wystarcza, by stworzyć obraz, który nie musi być w pełni zgodny z rzeczywistością, ale z pewnością będzie bardzo bogaty.

Z tego bogactwa korzystają różne publiczne instytucje. Może się ono okazać ważnym źródłem wiedzy dla policji i innych służb, których zadaniem jest stanie na straży szeroko pojętego bezpieczeństwa i porządku. Ale – co już mniej oczywiste, a bardziej prozaiczne – z informacji na temat aktywności użytkowników Internetu mogą korzystać również urzędy prowadzące swoje strony internetowe. Ostatnia część przewodnika opisuje, jakie cyfrowe ślady zostawia każdy z nas oraz jakimi narzędziami dysponują publiczne instytucje, by móc je wykorzystać w swojej działalności.

CIEKAWSKIE SERWISY

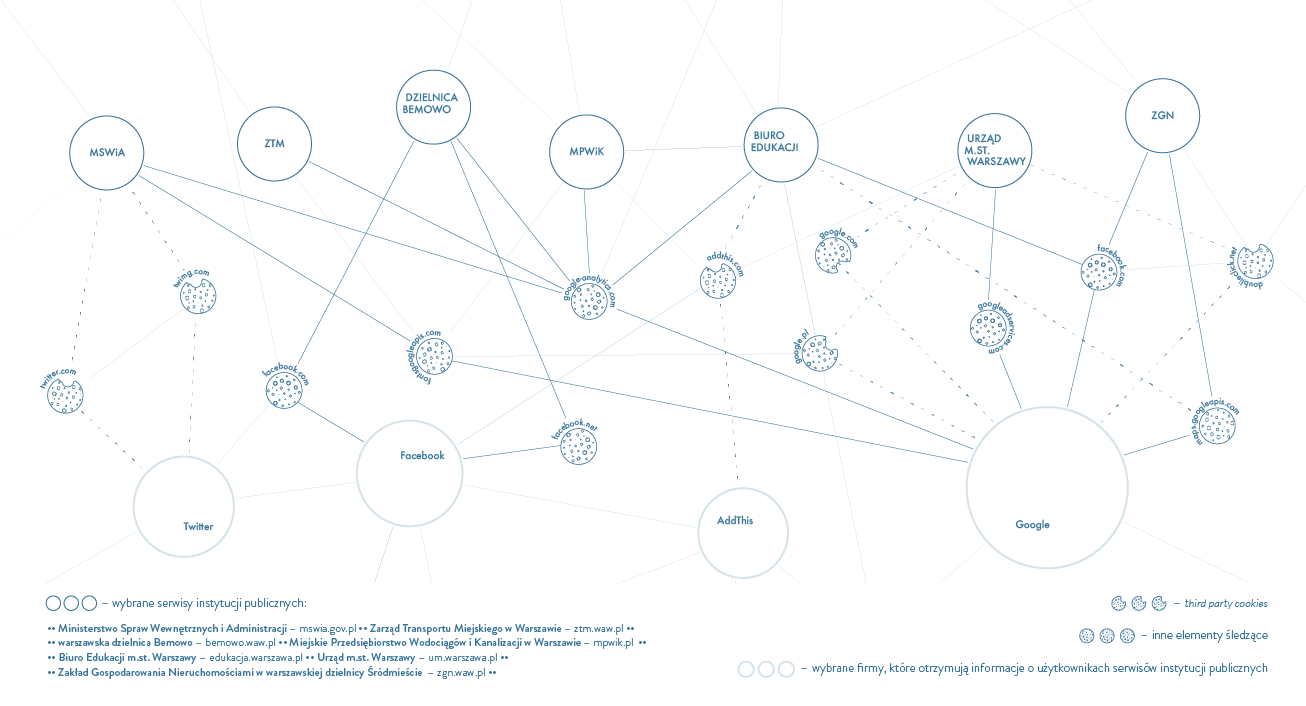

Dzisiaj właściwie każda instytucja publiczna dysponuje własną stroną internatową. Dla obywateli to duże ułatwienie – internetowe serwisy pozwalają szybko znaleźć przydatne materiały i informacje: formularze urzędowe, zapowiedzi ważnych wydarzeń, godziny otwarcia urzędów, numery telefonów czy rozkłady jazdy komunikacji miejskiej. Instytucje publiczne – tak jak inni administratorzy, a może nawet bardziej – powinny dbać o ochronę prywatności użytkowników. W przypadku firm często przeważa chęć wykorzystywania informacji w celach komercyjnych. Instytucje publiczne nie kierują się chęcią zysku, a jednak na ich stronach można znaleźć sporo elementów śledzących. Decydująca okazuje się zapewne wygoda lub zwykły brak świadomości, jakie konsekwencje niesie korzystanie z nich.

Ciasteczkowe potworki

Już samo wejście na dowolną stronę internetową uruchamia przepływ danych. Administrator serwisu automatycznie uzyskuje: adres IP użytkownika oraz informacje o przeglądarce, z której korzysta (m.in. jej wersję, system operacyjny, język). Strony internetowe wykorzystują różne mechanizmy służące pozyskaniu informacji. Najpopularniejsze są ciasteczka (ang. cookies), czyli specjalne pliki zapisywane na komputerze użytkownika. Służą powiązaniu internetowych aktywności z konkretną osobą. Część z nich jest niezbędna do prawidłowego wyświetlania strony, logowania bądź zapisania wyników ankiety, inne jednak pozwalają zdobyć dodatkowe informacje o aktywności odwiedzających.

Fundacja Panoptykon zbadała, jakie Dowiedz się więcejinformacje o użytkownikach zbierane są na stronach 70 różnych publicznych instytucji. Za pomocą dodatków do przeglądarki internetowej: Lightbeam (dostępny dla Firefoksa) oraz Disconnect i Ghostery przetestowała strony wszystkich ministerstw, policji i innych służb, wszystkich miast wojewódzkich i wybranych powiatowych (konkretnie strony urzędów miast i lokalnych zakładów komunikacji), ZUS i NFZ – w tym ich oddziałów – oraz GIODO. W przypadku ministerstw dodatkowo przeanalizowane zostały dostępne na stronach internetowych polityki prywatności.

Wnioski? Instytucje publiczne powszechnie korzystają z różnych aplikacji i wtyczek pozwalających na zbieranie informacji o osobach odwiedzających ich serwisy oraz zapisują ciasteczka na wykorzystywanych do tego urządzeniach. Wśród aplikacji zbierających informacje o użytkownikach najczęściej stosowane są programy o charakterze analitycznym, które pomagają dowiedzieć się m.in. tego, jak korzystają oni ze strony, jakie informacje ich interesują i w jaki sposób wyszukują konkretne treści (czy bezpośrednio na stronie, czy poprzez wyszukiwarki internetowe). Statystyki odwiedzin są dla każdego administratora serwisu bardzo przydatne, jednak oprócz nich programy analityczne mogą zbierać o wiele więcej informacji o odwiedzających, niż jest to niezbędne do zarządzania stroną – nawet dane pozwalające na ich identyfikację.

Jeśli instytucje publiczne sięgają po narzędzia łączące ich strony z zewnętrznymi serwisami, to dzielą się z nimi informacjami o sposobie korzystania z danej strony przez użytkowników.

Zbieranie nadmiernej ilości informacji to nie jedyny problem. Ważną kwestią jest również to, że wykorzystywane programy mogą przekazywać je dalej różnym zewnętrznym podmiotom, w tym zagranicznym firmom. Służą do tego specjalne wtyczki, które zapisują na sprzęcie użytkowników ciasteczka należące do podmiotów zewnętrznych, tzw. third party cookies. Jeśli instytucje publiczne sięgają po narzędzia łączące ich strony z zewnętrznymi serwisami, to dzielą się z nimi informacjami o sposobie korzystania z danej strony przez użytkowników, a tych ostatnich (o ile nie włączą oni odpowiednich blokad) zmuszają do akceptowania polityk prywatności komercyjnych podmiotów.

Third party cookies pojawiają się na prawie wszystkich monitorowanych publicznych serwisach. Zdecydowanie najbardziej popularne są wtyczki należące do Google’a (w tym przede wszystkim Google Analytics, wyszukiwarka, mapy, Google+, YouTube), często wykorzystywane są też wtyczki Facebooka czy Twittera. Zdarza się, że nie są one obecne na stronach głównych, ale wystarczy wejść nieco głębiej, by szybko na nie trafić. Google Analytics – najpopularniejszej aplikacji służącej do zbierania i analizy informacji o tym, jak użytkownicy korzystają z danej strony – używa większość ministerstw, znaczna część urzędów miast czy oddziałów NFZ. Decydują się one w ten sposób przekazywać firmie Google nie tylko informacje o popularności swojej strony internetowej, ale też o sposobie korzystania z niej przez poszczególnych użytkowników. Powiększa to zbiór informacji, którym ta firma dysponuje (a jest on bardzo duży, choćby ze względu na popularność jej produktów i fakt, że Google łączy informacje pochodzące ze swoich usług, na przykład z wyszukiwarki, poczty, YouTube’a, Google+, Picasy).

Inne popularne rozwiązanie Google’a to wyszukiwarka zintegrowana z serwisem danej instytucji. W takim przypadku wpisanie zapytania w okno wyszukiwania na stronie w rzeczywistości oznacza skorzystanie z wyszukiwarki Google. Co ciekawe, umożliwiająca taką integrację wtyczka umieszczona jest na przykład na stronie GIODO, czyli instytucji powołanej do stania na straży prywatności.

Spora część administratorów publicznych serwisów korzysta z wtyczek portali społecznościowych, które bezpośrednio na stronie instytucji pozwalają na „polubienie” konkretnego materiału lub nawet wyświetlają treści pojawiające się na profilu danej instytucji na portalu społecznościowym – robi tak na przykład Ministerstwo Spraw Wewnętrznych i Administracji oraz Centralne Biuro Antykorupcyjne (CBA). W tym przypadku informacje, ile czasu użytkownik spędził na stronie czy co czytał, mogą być połączone z bogactwem informacji gromadzonych w portalach społecznościowych. A co ważne, Facebook nie tylko wzbogaca dzięki temu profile osób, które korzystają z jego usług, ale tworzy również profile-cienie tych, których nie uda mu się rozpoznać jako swoich użytkowników.

Niektóre portale samorządowe szczególnie upodobały sobie instalowanie third party cookies. Na przykład oficjalna strona urzędu miasta Wrocławia serwuje ciasteczka z 10 innych serwisów (tylko 2 z nich wyglądają na powiązane miejskie strony), a strona Gdańska – z 9 innych portali. Jest to szczególnie ważne, ponieważ lokalne portale cieszą się zazwyczaj popularnością i są odwiedzane przez spore rzesze użytkowników.

Rzadziej, ale jednak, instytucje publiczne wykorzystują wtyczki o charakterze marketingowym, które pozwalają na określenie, jakie treści pokażą się odbiorcom z konkretnego obszaru, czy na dopasowanie reklam do ich statystycznie określonych preferencji – taką wtyczką o nazwie DoubleClick posługuje się choćby Ministerstwo Spraw Zagranicznych. Część komunikatów (na przykład ostrzeżenia o zagrożeniach czy informacje, gdzie szukać pomocy) przygotowywanych przez Ministerstwo zapewne skierowana jest do osób przebywających na określonym terytorium. Możliwość geograficznego sprofilowania komunikacji w niektórych przypadkach może mieć uzasadnienie, ale znowu warto się zastanowić, czy powinno się to odbywać za pośrednictwem aplikacji, które mogą przekazywać dane podmiotom trzecim.

Korzystanie z wtyczek analitycznych czy społecznościowych oferowane jest za darmo, a przynajmniej tak to wygląda na pierwszy rzut oka. W rzeczywistości często płaci się za to informacjami o użytkownikach stron.

Korzystanie z wtyczek analitycznych czy umożliwiających dzielenie się treściami na portalach społecznościowych oferowane jest za darmo, a przynajmniej tak to wygląda na pierwszy rzut oka. W rzeczywistości często płaci się za to informacjami o użytkownikach stron, co zwiększa potencjał i zyski firm internetowych, które oferują „darmowe” aplikacje. Aspekt finansowy jest ważny – instytucje publiczne powinny w rozsądny sposób dysponować środkami – jednak podmioty te jako administratorzy stron internetowych powinny również uwzględnić potrzebę zachowania prywatności użytkowników i poszukać rozwiązań, które pozwalają na większą kontrolę nad informacjami, na przykład sięgać po mniej znane, ale i mniej śledzące, rozwiązania techniczne.

SŁUŻBY W GĄSZCZU DANYCH

Na początku 2016 r. spore poruszenie wywołała ustawa zwana potocznie inwigilacyjną. Przyznała ona policji i innym służbom szersze możliwości dostępu do danych dotyczących aktywności w Internecie. Społeczny niepokój był uzasadniony. Nie oznacza to jednak, że wcześniej służby nie mogły sięgać po dane internetowe czy podążać tropem innych naszych cyfrowych śladów. Mogły to robić i z tej możliwości korzystały. A teraz mogą to robić na jeszcze szerszą skalę.

Dane w służbie bezpieczeństwa

Im powszechniej korzystamy z telefonu czy rozmaitych urządzeń podłączonych do Internetu, tym więcej danych do analizowania mają policja, ABW, CBA, Służba Celna i inne służby. W ramach prewencji czy ścigania sprawców przestępstw podejmują różnorodne działania, które w mniejszym lub większym stopniu mogą ingerować w naszą prywatność. W przypadku policji może to być na przykład:

- wstępne rozpoznanie zagrożenia, które może się wiązać z pobraniem informacji dotyczących szerokiego kręgu osób;

- analiza zebranych danych, na przykład analiza połączeń telefonicznych czy sieci społecznościowych (w ramach tzw. analizy kryminalnej);

- dalsza, pogłębiona inwigilacja już określonych osób lub urządzeń, która może polegać m.in. na przechwytywaniu komunikatów;

- zabezpieczenie dowodów na potrzeby sprawy karnej, co może się wiązać z koniecznością złamania zabezpieczeń telefonu czy komputera i wydobyciem danych z pamięci urządzenia (w ramach tzw. informatyki śledczej).

Im szerzej zakrojone są działania służb w sieci, tym bardziej warte są uwagi. Bardzo często są one bowiem poza jakąkolwiek kontrolą, a jednocześnie siłą rzeczy dotykają również ludzi, którzy nie mają nic wspólnego z naruszeniami prawa. O ile zastosowanie inwigilacji wobec określonej osoby w wielu przypadkach wymaga zgody sądu, o tyle szeroko zakrojone zbieranie i przetwarzanie metadanych czy analizowanie ruchu w sieci – już nie. W dodatku działania służb w tym obszarze mają co do zasady tajny charakter, więc nawet jeśli ktoś znajdzie się w orbicie ich zainteresowania, może nigdy się o tym nie dowiedzieć.

Ogrom informacji dostępnych w sieci to dla służb jednocześnie Eldorado i stajnia Augiasza. Z jednej strony – znaleźć można tam niemal wszystko, a z drugiej – szalenie łatwo się pogubić.

Ogrom informacji dostępnych w sieci to dla służb jednocześnie Eldorado i stajnia Augiasza. Z jednej strony – znaleźć można tam niemal wszystko, a z drugiej – szalenie łatwo się pogubić. Żeby trafić na coś interesującego, czasami niezbędne okazują się potężne zdolności analityczne – algorytmy, zaawansowane techniki profilowania ludzi i kojarzenia danych. Naprzeciw tym szansom i wyzwaniom wychodzi oczywiście biznes i instytucje badawcze, proponując rozwiązania techniczne, które mają ułatwić służbom życie. Spektrum dostępnych narzędzi jest szerokie. Z czego służby korzystają w praktyce?

Paradoksalnie więcej można powiedzieć o działaniu amerykańskich służb niż ich polskich odpowiedników. Wiedzę tę zawdzięczamy byłym pracownikom agencji wywiadowczych USA, którzy zdecydowali się głośno krytykować system, który wcześniej współtworzyli. Jego założeniem było zasysanie i analizowanie właściwie wszystkiego, co pojawia się w sieci. Takie działanie nie byłoby możliwe bez biznesu – nie tylko tworzącego coraz bardziej zaawansowane narzędzia, ale też przejmującego część zadań należących do służb. Pewne wyobrażenie o skali i znaczeniu tej współpracy dają liczby – amerykańskie media szacują, że w przypadku samej Narodowej Agencji Bezpieczeństwa (NSA, od ang. National Security Agency) w grę wchodzą kontrakty na 6 miliardów dolarów rocznie.

Zdaniem Michaela Haydena, człowieka, który nadzorował prywatyzację inwigilacyjnych zadań NSA między 1999 a 2005 r., „największa koncentracja cybermocy na naszej planecie znajduje się na rogu Baltimore Parkway i Maryland Route 32”. To aluzja do lokalizacji parku biznesowego zajmowanego przez firmy świadczące usługi na rzecz amerykańskich służb. Jedną z najbardziej wpływowych jest Narus – spółka należąca do Boeinga, która dostarcza agencjom rządowym kluczowe oprogramowanie, pozwalające na monitorowanie i przechwytywanie olbrzymich ilości danych bezpośrednio ze światłowodów. Inna firma – były pracodawca Edwarda Snowdena, czołowego amerykańskiego sygnalisty (ang. whistleblower), który ujawnił skalę inwigilacji prowadzoną przez NSA – to Booz Allen Hamilton. Jest ona zaangażowana w zasadzie w każdy aspekt pracy wywiadowczej: od doradzania wysokiej rangi urzędnikom, przez obsługę technicznej infrastruktury, po analizę i integrację pozyskiwanych danych. Lista zleceniobiorców NSA jest o wiele dłuższa, są na niej mniej i bardziej rozpoznawalne firmy, takie jak SAIC, TRW czy Palantir Technologies.

Zdaniem krytyków taki system, oparty na powszechnej inwigilacji, nie tylko godzi w prawa człowieka i pochłania ogromne pieniądze, ale też generuje liczne błędy i jest w gruncie rzeczy nieskuteczny. William Binney, były analityk amerykańskiej NSA, matematyk specjalizujący się w sieciowej analizie danych, w następujący sposób opisuje w wywiadzie opublikowanym na łamach Gazety Wyborczej „porażkę masowej inwigilacji”: „Gromadzenie terabajtów przypadkowych danych sprawia, że NSA nie jest w stanie ich analizować. Codziennie gromadzi dane telekomunikacyjne – lokalizację, połączenia telefoniczne i internetowe, łącznie z treścią rozmów, SMS-ów i e-maili – około czterech miliardów ludzi. Aby to miało sens, jeden pracownik musiałby skontrolować dziennie 200 tys. osób. Przywaleni danymi funkcjonariusze zarzucili analizę kierunkową – jedyną, która może wykryć rzeczywiste zagrożenia – na rzecz prostego przeszukiwania baz danych po słowach kluczowych. To daje mnóstwo nic nieznaczących »trafień« zamiast wiedzy o istotnych powiązaniach między danymi”.

Zdaniem samych sygnalistów najprostszym i najtańszym rozwiązaniem tego problemu byłoby zbieranie o wiele mniejszej ilości danych, za to w oparciu o lepsze rozpoznanie siatek przestępczych i uprzednią analizę powiązań między ludźmi komunikującymi się w globalnej sieci. Do podobnych wniosków prowadzą wyniki projektu badawczego SURVEILLE. Po zestawieniu wszystkich badanych aspektów – od oceny prawnej i etycznej po użyteczność w rozumieniu samych praktyków – najlepsze wyniki osiągnęły w ocenie badaczy „tradycyjne” techniki nadzoru.

W ujawnionych informacjach dotyczących działania amerykańskiego systemu inwigilacji można znaleźć rodzime tropy. Polska została zaklasyfikowana przez NSA do grupy 19 państw, z którymi amerykańska służba prowadzi „skupioną współpracę”.

W ujawnionych informacjach dotyczących działania amerykańskiego systemu inwigilacji można znaleźć rodzime tropy. Polska została zaklasyfikowana przez NSA do grupy 19 państw, z którymi amerykańska służba prowadzi „skupioną współpracę”. To jedynie poziom niżej od „wszechstronnej współpracy” z państwami tzw. sojuszu pięciorga oczu, obejmującego poza Stanami Zjednoczonymi również Wielką Brytanię, Kanadę, Australię i Nową Zelandię. Wedle materiałów dołączonych do książki Glenna Greenwalda Snowden. Nigdzie się nie ukryjesz polskie służby przekazywały Amerykanom dane w ramach programów ORANGECRUSH i OAKSTAR. A serwis publikujący dokumenty pochodzące od sygnalistów Cryptome udostępnił jakiś czas temu serię tabel finansowych NSA. Wynika z nich, że Amerykanie prowadzili w Polsce działania, w których partnerem była Agencja Wywiadu.

W 2013 r. w ramach akcji Dowiedz się więcej„100 pytań o inwigilację” Fundacja Panoptykon, Amnesty International Polska i Helsińska Fundacja Praw Człowieka skierowały serię wniosków o informację publiczną dotyczących polsko-amerykańskiej współpracy. Jedynie CBA odpowiedziało przecząco. Natomiast inne służby na różne sposoby próbowały wymigać się od odpowiedzi (z częścią z nich trwa walka o te informacje w sądzie).

Amerykański kompleks przemysłowo-inwigilacyjny nie pozwala na wyciąganie wniosków o polskiej rzeczywistości, ale daje pojęcie o zapotrzebowaniu i trendach, jakim niewątpliwie podlegają również nasze służby. Nic nie wskazuje jednak na to, by system przypominający amerykański mógł u nas funkcjonować. Polskie służby nie dysponują środkami porównywalnymi z amerykańskimi (roczny budżet ABW wynosi 500 mln zł), a obowiązujące prawo – przynajmniej na razie – nie pozwala na przykład na masowe zasysanie informacji objętych tajemnicą korespondencji. Jednak służbom pozostawiono dużą elastyczność, jeśli chodzi o dostęp do metadanych oraz wykorzystywane narzędzia. Ustawodawca wyszedł z założenia, że technologia się zmienia, praktyczne środki dostępne również, a więc prawo musi w tym zakresie dawać pewną swobodę.

Obowiązująca w służbach kultura tajności sprawia, że wiedza na temat ich działań jest bardziej niż niepełna. Nie ulega wątpliwości, że niektóre aspekty tej działalności muszą pozostać niejawne, jednak – szczególnie w przypadku narzędzi wykorzystywanych do prewencyjnego zbierania i analizowania informacji o szerokiej grupie obywateli – pewien minimalny poziom transparentności jest niezbędny.

Informacje publicznie dostępne

Informacje dostępne w Internecie to prawdziwa kopalnia wiedzy – również dla różnego rodzaju służb. Zbieranie i analiza informacji z otwartych zasobów internetowych (OSINT od ang. open source intelligence) to wbrew pozorom bardzo ważne narzędzie ich pracy. Bez kontrowersji towarzyszących bardziej inwazyjnym formom inwigilacji, przełamywania zabezpieczeń czy uzyskiwania nakazów sądowych mają one dostęp do wielu cennych informacji.

Służby mogą wykorzystywać publicznie dostępne zasoby nie tylko do wyłuskiwania informacji o zainteresowaniach czy działaniach poszczególnych osób, ale także o powiązaniach między nimi, zjawiskach, trendach itd.

Jak wiele można wyczytać o drugim człowieku z sieci, wie każdy, kto – choćby z ciekawości – analizował profil innej osoby na portalu społecznościowym. Służby są w stanie wyciągnąć z tego jeszcze więcej. Mogą one bowiem wykorzystywać publicznie dostępne zasoby nie tylko do wyłuskiwania informacji o zainteresowaniach czy działaniach poszczególnych osób, ale także o powiązaniach między nimi, zjawiskach, trendach itp. Te możliwości są wykorzystywane choćby do prowadzenia białego wywiadu (na przykład dotyczącego zagrożeń energetycznych), przeciwdziałania „ustawkom” kibiców czy innym niebezpiecznym działaniom, ścigania mowy nienawiści czy naruszeń praw autorskich.

Nie są to jednak działania tak proste, jak mogłoby się wydawać na pierwszy rzut oka. Tak jak każdy z nas może utonąć w morzu informacji dostępnych w Internecie, tak samo toną w nich służby. Dlatego zaczynają sięgać po mniej lub bardziej wyrafinowane algorytmy, sztuczną inteligencję, techniki profilowania ludzi i kojarzenia danych. Rynek narzędzi OSINT, które pomagają poruszać się w tym gąszczu informacji, jest bardzo bogaty. Dostępne rozwiązania (na przykład Prompt Cloud, Palantir Metropolis) z jednej strony pozwalają automatycznie przeszukiwać dostępne treści (strony internetowe, fora, blogi, portale społecznościowe), a z drugiej – analizować dostępne dane.

Analiza open source obejmuje:

- przeszukiwanie dostępnych treści pod kątem zdefiniowanych kryteriów, na przykład słów kluczowych;

- wyłapywanie powiązań między faktami, analizę trendów;

- mapowanie relacji i interakcji między ludźmi, analiza wzorców komunikacji w konkretnych grupach;

- analizę treści stron, nastroju i stylu piszącego;

- wizualizację danych.

Dostępne jest również oprogramowanie (na przykład Baseprotect, Logistep) wyspecjalizowane w monitorowaniu ruchu w sieciach P2P (ang. peer-to-peer) pod kątem możliwych naruszeń praw autorskich. Wykorzystuje ono otwarty dostęp do takich sieci i techniczną możliwość analizowania, jakie pliki są aktualnie przesyłane oraz przez kogo. Nie wymaga ona przełamywania jakichkolwiek zabezpieczeń, nie jest się jednak w stanie obejść bez rozbudowanej infrastruktury.

Wiele rozwiązań jest powszechnie dostępnych i korzystają z nich nie tylko służby, ale również podmioty prywatne. Jednak instytucje, które swoje działanie opierają na systemach masowej inwigilacji, inwestują w oprogramowanie „krojone na miarę”. Na przykład, zgodnie z informacjami ujawnionymi przez Edwarda Snowdena, amerykańska NSA korzysta m.in. z aplikacji MARINA, która pozwala tworzyć indywidualne profile internautów, a brytyjska GCHQ – z systemu SQUEAKY DOLPHIN pomagającego analizować w czasie rzeczywistym posty publikowane na najpopularniejszych platformach internetowych, na przykład na Facebooku.

A jak to wygląda w Polsce? Policja przyjmuje, że może zbierać i analizować zasoby powszechnie dostępne w Internecie w ramach czynności operacyjno-rozpoznawczych i dochodzeniowo-śledczych bez zgody sądu. Nie jest przy tym w pełni jasne, jaki standard ochrony praw obywateli i kontroli nad działaniami służb obowiązuje w tym przypadku.

Z informacji publikowanych przez Polską Platformę Bezpieczeństwa Wewnętrznego wynika, że polska policja dysponuje na przykład pakietem narzędzi informatycznych wspomagających poszukiwanie nielegalnych materiałów wysyłanych w trybie P2P oraz systemem IBIS służącym do monitorowania publicznie dostępnych usług internetowych. Z odpowiedzi na wnioski o informację publiczną wynika, że Służba Celna korzysta z serii narzędzi służących do monitoringu i analizy takich treści (EMM Osint Suite, WebSite-Watcher, Paterva Maltego).

Co ciekawe, do tej pory największe kontrowersje wzbudziły w Polsce wcale nie narzędzia faktycznie wykorzystywane, a program badawczy. Projekt INDECT (Intelligent information system supporting observation, searching and detection for security of citizens in urban environment) był realizowany przez konsorcjum polskich i zagranicznych uczelni i instytucji, w tym Komendę Główną Policji, formalnie reprezentowaną przez Ministerstwo Spraw Wewnętrznych. Służby o swoich narzędziach wolą milczeć, tymczasem stojąca na czele projektu krakowska Akademia Górniczo-Hutnicza aktywnie promowała projekt i ideę tworzenia narzędzi rozpoznających „podejrzane zachowania”, również w sieci. Wywołało to niepokój części opinii publicznej i poważny kryzys komunikacyjny. Ministerstwo Spraw Wewnętrznych poinformowało nawet o „zawieszeniu udziału w projekcie INDECT ze względu na konieczność poszanowania prawa obywateli do prywatności”. Jednocześnie nigdy formalnie nie wycofało się z projektu, stawiając na przeczekanie burzy. A ta z czasem ucichła.

Oczywiście inicjatyw badawczych mających podobne ambicje jest w Polsce i na świecie wiele. Warto wspomnieć choćby o projekcie realizowanym przez Narodowe Centrum Badań i Rozwoju, w ramach którego tworzone jest narzędzie służące do integracji i analizy danych dostępnych powszechnie w sieci pod kątem wyłapywania informacji o zagrożeniach w cyberprzestrzeni.

Metadane, czyli tropem cyfrowych śladów

Ślady pozostawiane w sieci nie ograniczają się do tego, co mniej lub bardziej intencjonalnie każdy z nas opublikuje (teksty, zdjęcia, filmy, statusy, polubienia itp.), lecz obejmują także informacje tworzone mimowolnie, niejako przy okazji aktywności w sieci. Każde kliknięcie zostawia po sobie ślad, który niemal zawsze można powiązać z konkretnym użytkownikiem (choćby dzięki opisywanym wyżej ciasteczkom). Wszystko to wygląda niepozornie, jednak na podstawie historii aktywności w danym serwisie czy interakcji z innymi można stworzyć całkiem dokładny profil konkretnej osoby. Administratorzy stron internetowych i reklamodawcy tworzą je najczęściej po to, żeby lepiej dopasować usługę do odbiorcy czy podsunąć mu „skrojoną na miarę” reklamę, ale jednocześnie stanowią one atrakcyjny informacyjny kąsek dla państwa i jego służb.

Naukowcy z Massachusetts Institute of Technology ustalili, że na podstawie danych telekomunikacyjnych tylko z jednego miesiąca można odtworzyć sieć kontaktów i w 90% przypadków ustalić tożsamość osób należących do tej sieci.

Kolejnych szczegółowych informacji o codziennym życiu Dowiedz się więcejdostarcza telefon komórkowy. Nawet jeśli nie jest wykorzystywany do korzystania z Internetu, pozwala on gromadzić informacje o wszystkich nawiązywanych i odbieranych połączeniach czy komunikacji esemesowej oraz jest nadajnikiem, który na bieżąco komunikuje się ze stacjami BTS, informując operatora o lokalizacji swojego właściciela. Naukowcy z Massachusetts Institute of Technology ustalili, że na podstawie danych telekomunikacyjnych tylko z jednego miesiąca można odtworzyć sieć kontaktów i w 90% przypadków ustalić tożsamość osób należących do tej sieci. Co więcej – aż w 95% przypadków na podstawie danych telekomunikacyjnych można przewidzieć, gdzie dana osoba znajdzie się w ciągu kolejnych 12 godzin. Dlatego świetnie nadają się one do analizowania tras poruszania się czy ustalenia sieci kontaktów – zarówno za pomocą telefonu, jak i twarzą w twarz (dzięki geolokalizacji). A stąd już tylko krok od ustalenia charakteru danej relacji.

Dane telekomunikacyjne miały stać się jednym z głównych oręży w walce z terroryzmem. Na fali strachu wywołanego zamachami w Madrycie i Londynie dyrektywą z 2006 r. wprowadzono w Unii Europejskiej obowiązek przechowywania tych danych przez operatorów i udostępniania ich na żądanie służb i innych publicznych instytucji. Polskie władze początkowo zdecydowały się na maksymalny, dwuletni okres zatrzymywania danych. Dopiero w styczniu 2013 r., na skutek społecznej krytyki, został on skrócony do 12 miesięcy.

W teorii dane telekomunikacyjne miały być wykorzystywane przede wszystkim do walki z najpoważniejszą przestępczością. W Polsce jednak umożliwiono sięganie po nie również w najdrobniejszych sprawach, a nawet prewencyjnie.

W teorii dane telekomunikacyjne miały być wykorzystywane przede wszystkim do walki z najpoważniejszą przestępczością: terroryzmem czy handlem ludźmi. W Polsce jednak umożliwiono sięganie po nie m.in. policji i kilku innym służbom również w najdrobniejszych sprawach, a nawet prewencyjnie. I to bez żadnej zewnętrznej kontroli. Choć w 2014 r. Trybunał Sprawiedliwości Unii Europejskiej orzekł, że Dowiedz się więcejdyrektywa retencyjna jest nieważna, a polski Trybunał Konstytucyjny zakwestionował zasady dostępu do tych danych, niewiele się od tej pory zmieniło. Nowe przepisy obowiązujące od lutego 2016 r. (wprowadzone tzw. ustawą inwigilacyjną) przewidują jedynie pozorny mechanizm kontrolny: służby co pół roku mają składać do sądu specjalne sprawozdanie.

W Polsce źródłem metadanych telekomunikacyjnych są w tym momencie przede wszystkim bazy danych czterech największych operatorów telekomunikacyjnych. Służby nie muszą ich jednak prosić o udostępnianie danych – same mogą po nie sięgać za pomocą stałych łączy i specjalnych interfejsów, które zostały wprowadzone na koszt operatorów. Oni też płacą (a ostatecznie ich klienci) za cały proces udostępniania danych telekomunikacyjnych.

Stałe łącza oraz brak konsekwencji finansowych i realnej kontroli przekładają się na skalę korzystania przez służby z tych danych. Dane przekazane przez operatorów do Urzędu Komunikacji Elektronicznej mówią o niespełna 2,4 mln pobrań w 2014 r., natomiast w odpowiedzi na pytania Fundacji Panoptykon sama tylko policja zadeklarowała, że sięgała po nie w tym czasie ponad 1,6 mln razy (i – nieco rzadziej – około 1,2 mln razy w 2015 r.). Dane te są niespójne i nie do końca wiarygodne, brakuje bowiem jednolitej metodologii liczenia zapytań. Jedno jest pewne: dane płyną z telekomów do służb szerokim strumieniem.

Policja tłumaczy, że skala zapytań wynika m.in. z metod, jakie standardowo się stosuje w pracy operacyjnej czy analizie danych. Każda nowa informacja o danym numerze telefonu to kolejne zapytanie, często kierowane osobno do każdego z operatorów. Namierzanie jednej bądź kilku podejrzanych osób odbywa się nieraz dzięki pobraniu i analizie informacji dotyczących wszystkich numerów, które w danym momencie łączyły się z konkretnymi stacjami BTS. W tym gąszczu informacji funkcjonariusze starają się znaleźć jakieś istotne tropy – w ich wyławianiu znowu mają pomagać narzędzia służące do analizy danych. Podobnie jak w przypadku opracowywania informacji z publicznie dostępnych źródeł część z nich to programy do analizy statystycznej wykorzystywane do wielu innych celów, inne są dedykowane działaniom analitycznym służb. W tym drugim przypadku mowa na przykład o środowisku LINK/MAMUT (opracowanym przez Polską Platformę Bezpieczeństwa Wewnętrznego) czy LINK2 (efekcie pracy naukowców z Akademii Górniczo-Hutniczej). Zgodnie z medialnymi doniesieniami policja korzysta również z Analizatora Faktów i Związków (oprogramowania stworzonego na Politechnice Poznańskiej).

Policja i inne służby mają też dostęp do danych przetwarzanych przez dostawców usług internetowych, czyli na przykład administratorów portali informacyjnych, społecznościowych czy sklepów internetowych. Przez lata sięganie po nie odbywało się na zupełnie innych zasadach niż w przypadku danych telekomunikacyjnych. Nie było mowy o bezpośrednim dostępie do tych informacji. Obowiązujące prawo budziło wprawdzie wątpliwości interpretacyjne, jasne było jednak, że aby uzyskać dostęp do danych użytkowników usług internetowych, służby muszą do firmy świadczącej takie usługi zwrócić się Dowiedz się więcejz wnioskiem lub postanowieniem wskazującym podstawę prawną. Firmy rozpatrywały je według wewnętrznych procedur, zdarzało się, że kwestionowały żądania i odmawiały udostępniania danych.

Taki stan rzeczy znajdował odbicie w skali sięgania po dane internetowe. Choć dostępne informacje na ten temat są jeszcze bardziej dziurawe niż w przypadku danych telekomunikacyjnych, nie ma wątpliwości, że Dowiedz się więcejdane internetowe były udostępniane o wiele rzadziej. Policja w 2014 r. sięgała po nie około 50 tys. razy, ale w 2015 r. – już ponad 200 tys. razy. Dynamika wzrostu zwraca uwagę, choć w porównaniu z liczbą pobrań danych telekomunikacyjnych (sięgającą odpowiednio 1,6 i 1,2 miliona) liczby bezwzględne nie robią już takiego wrażenia.

Tzw. ustawa inwigilacyjna ułatwiła służbom dostęp do danych internetowych. W połączeniu z brakiem realnych mechanizmów kontroli może to sprawić, że dane te popłyną do służb równie szerokim strumieniem, jak dane telekomunikacyjne.

W 2016 r. sytuacja może wyglądać już zgoła inaczej. Dowiedz się więcejTzw. ustawa inwigilacyjna, która weszła w życie w lutym, ułatwiła służbom dostęp do danych internetowych. Teraz – podobnie jak dane telekomunikacyjne – mogą one być pobierane również poza konkretnym postępowaniem oraz za pomocą stałego łącza i dedykowanego interfejsu. W połączeniu z brakiem realnych mechanizmów kontroli może to sprawić, że dane internetowe popłyną do służb równie szerokim strumieniem, jak dane telekomunikacyjne. Tym samym pojawi się okazja do korzystania z narzędzi analitycznych na szerszą skalę oraz wdrażania nowych rozwiązań.

Policja i inne służby mogą również przechwytywać dane bezpośrednio z Internetu i analizować je. W przypadku metadanych polega to przede wszystkim na bieżącym monitoringu sieci w celu wyłapania konkretnych korzystających z niej adresów IP. Na rynku dostępna jest długa lista narzędzi, które można wykorzystać do tego celu – zarówno rozwiązań komercyjnych (IPCopper, FireEye), jak i wolnego oprogramowania (Wireshark). Takie działania są rutynowo prowadzone przez operatorów w ramach dbania o bezpieczeństwo sieci, zapobiegania cyberatakom, blokowania spamu czy szeroko pojętego zarządzania ruchem. Obowiązuje ich jednak zakaz zaglądania do wnętrza pakietów, czyli monitoringu treści.

Komunikacja i prywatne treści

Interesująca dla służb może być oczywiście również treść komunikacji (SMS-y, e-maile, wiadomości na portalach społecznościowych czy czatach) oraz rozmaite materiały (filmy, zdjęcia, dokumenty), powszechnie zapisywane nie tylko na komputerach czy telefonach, ale też w chmurze (nie zawsze ze świadomością, że trafiają na serwery na drugim końcu świata). Zazwyczaj jednak te informacje są lepiej chronione niż metadane dotyczące aktywności w sieci. Jeśli na przykład policja miałaby uzyskać do nich dostęp bez wiedzy użytkownika, powinno się to odbyć w ramach kontroli operacyjnej, czyli tak jak w przypadku zakładania podsłuchu – za zgodą sądu.

Nie udało się namierzyć żadnych komercyjnych produktów, które umożliwiałyby bezpośredni dostęp do danych przechowywanych na wirtualnych serwerach, czyli w chmurze. Dostęp ten jest jednak możliwy, z jednej strony dzięki narzędziom stworzonym na zlecenie samych służb (w przypadku amerykańskiej NSA wypracowywanych na przykład przez firmę Booz Allen Hamilton), a z drugiej – dzięki współpracy komercyjnych podmiotów, które sprawują nad nimi kontrolę. Na dostępie do danych gromadzonych na serwerach amerykańskich informatycznych potentatów (Google’a, Yahoo, Microsoftu czy Apple) opierał się jeden z filarów amerykańskiego programu masowej inwigilacji, czyli PRISM.

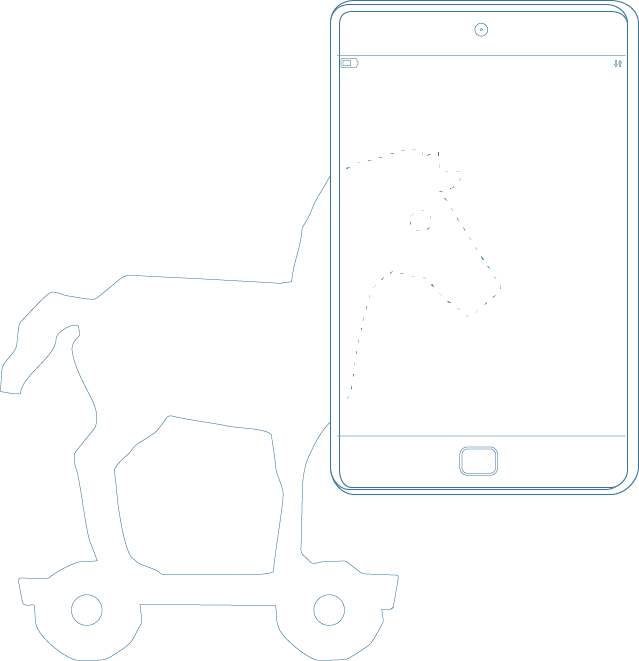

Dostępne na rynku jest natomiast oprogramowanie umożliwiające zdalne infekowanie sprzętu – tzw. konie trojańskie. Ani policja, ani inne polskie służby nie chcą udzielać informacji na temat korzystania z tego rodzaju narzędzi. Nowe światło na sprawę rzucił natomiast Dowiedz się więcejwyciek danych, z którego wynikało, że w 2012 r. CBA za 178 tys. euro kupiło od włoskiej firmy Hacking Team licencję na oprogramowanie Remote Control System, a w kolejnych latach płaciło ponad 35 tys. euro rocznie za wsparcie techniczne.

W 2012 r. CBA za 178 tys. euro kupiło od włoskiej firmy Hacking Team licencję na oprogramowanie Remote Control System – platformę służąca do infekowania, a następnie zdalnego i ukrytego kontrolowania sprzętu elektronicznego.

Dowiedz się więcejRemote Control System to platforma służąca do infekowania, a następnie zdalnego i ukrytego kontrolowania urządzeń takich jakich komputery i telefony komórkowe. Po przejęciu kontroli nad wybranym urządzeniem pozwala utrwalać wszystkie czynności jego użytkownika: oglądać odwiedzane przez niego strony, czytać przesyłaną pocztę, słuchać rozmów wykonywanych przez Skype’a, a nawet przechwytywać wpisywane hasła. Przeprowadzona przez społeczność hakerską analiza kodu Remote Control System daje podstawy, by sądzić, że to narzędzie umożliwiało również modyfikowanie treści na zainfekowanych urządzeniach, co może być – przynajmniej w teorii – wykorzystywane na przykład do podrzucania fałszywych dowodów.

Zakres możliwości technicznych, jakie stwarzała licencja wykupiona przez CBA, nie jest jasny. Wiadomo tylko, że pozwalała na zainfekowanie do 10 komputerów, bez możliwości zarażania urządzeń mobilnych. Zagadką pozostaje również, czy i w jaki sposób była wykorzystywana w praktyce.

Zdaniem krytyków stosowanie takich narzędzi jak konie trojańskie uderza w podstawy bezpieczeństwa w sieci i jako takie powinno być zakazane bez względu na okoliczności. Obecnie jednak ich wykorzystywanie jest na gruncie polskiego prawa dopuszczalne. Przepisy nie precyzują bowiem, z jakich konkretnie narzędzi służby mogą korzystać, sięgając po informacje dotyczące obywateli. To jeden z problemów, na które kilka lat temu w swoim wniosku do Trybunału Konstytucyjnego zwróciła uwagę ówczesna Rzecznik Praw Obywatelskich Irena Lipowicz. Sędziowie uznali jednak, że na poziomie przepisów nie ma potrzeby doprecyzowania uprawnień służb tak długo, jak sądy – wyrażając zgodę na kontrolę operacyjną – jasno wyznaczają jej granice, wskazując rodzaj środka technicznego, jaki może być wykorzystany do pozyskania informacji.

Większe wątpliwości interpretacyjne wiążą się z użyciem narzędzi, które pozwalają na dostęp do treści komunikacji i przesyłanych w sieci informacji, ale nie są wymierzone w konkretne osoby. Rodzaj monitoringu sieci, który umożliwia analizę przesyłanych treści, nazywa się „głęboką inspekcją pakietów” (DPI, od ang. Deep Packet Inspection). Technika ta umożliwia służbom kontrolę treści na przykład pod kątem naruszeń praw autorskich lub namierzanie materiałów dotyczących seksualnego wykorzystywania dzieci. Z nieoficjalnych rozmów z funkcjonariuszami policji wynika, że aż do momentu namierzenia konkretnej osoby i przechwytywania jej korespondencji nie traktują oni zbierania ani analizy danych z Internetu jako kontroli operacyjnej i korzystają z tych możliwości bez zgody sądu. Nie udało się jednak potwierdzić tych informacji w drodze oficjalnej korespondencji skierowanej do służb.

Podstawowe techniczne wyzwanie, z którym mierzą się służby chcące na bieżąco monitorować sieć, to „problem prędkości” – dostępne rozwiązania nie są w stanie rejestrować ani analizować danych tak szybko, jak są one przesyłane w Internecie. Dlatego rejestracja i analiza ruchu wymaga bardzo rozbudowanej infrastruktury albo przechwytywania tylko wyselekcjonowanych treści. Z perspektywy służb najprostszym rozwiązaniem jest „wpięcie” się w sieć operatora i zainstalowanie tam odpowiedniego oprogramowania. Żeby masowo przechwytywać lub analizować dane bez współpracy operatora, niezbędne byłoby kopiowanie ruchu sieciowego i przekierowywanie go do odpowiednich urządzeń.

Zgodnie z informacjami ujawnionymi przez sygnalistów takie działania prowadzi na przykład amerykańska NSA. Z nieformalnych rozmów z funkcjonariuszami wynika natomiast, że w Polsce analogiczne praktyki mogą być prowadzone przy współpracy z operatorami. Być może zmieni się to jednak po przyjęciu nowej strategii cyberbezpieczeństwa RP, której założenia przewidują szersze możliwości śledzenia ruchu w Internecie poprzez stworzenie systemu monitorowania w punktach wymiany ruchu internetowego.

Obok narzędzi wykorzystywanych do działań niejawnych służby korzystają z takich, które pomagają im w pracy na dalszym etapie postępowania – gdy w ich ręce trafia sprzęt należący do osób podejrzanych o popełnienie przestępstwa, posługują się narzędziami informatyki śledczej. Chodzi przede wszystkim o oprogramowanie, które pozwala uzyskać dostęp do zabezpieczonych laptopów, dysków zewnętrznych, tabletów i smartfonów, a także pozwala odzyskać skasowane dane. Zgodnie z informacjami medialnymi policja korzysta na przykład z oprogramowania XRY Office, a Żandarmeria Wojskowa w trybie przetargu nabyła EnCase Forensic.

Narzędzia poza kontrolą

Z zebranych informacji wynika, że w codziennej pracy służb wykorzystywane są różnorodne narzędzia – zarówno takie stworzone z myślą o służbach, jak i powszechnie dostępne programy służące na przykład analizie statystycznej. Przy czym nierzadko to samo narzędzie może realizować różne cele – od zbierania informacji, poprzez ich analizę, po odzyskiwanie z pamięci urządzeń i zabezpieczanie. Duża różnorodność dostępnych rozwiązań – od bardzo prostych po skomplikowane – znajduje odbicie w cenach komercyjnych produktów. Można wśród nich znaleźć programy, na które służby przeznaczyły niemal kieszonkowe kwoty (na przykład kilkaset złotych), i takie, które kosztowały miliony.

Osobną kategorią są narzędzia o niekomercyjnym charakterze, rozwijane w ramach projektów badawczych. Zwykle są one koordynowane lub wspierane przez Polską Platformę Bezpieczeństwa Wewnętrznego. Innym istotnym podmiotem jest Akademia Górniczo-Hutnicza, szczególnie Laboratorium Informatyki Śledczej i Intelligent Information Systems Group. Podmioty te chwalą się, że przekazują polskim służbom wypracowane przez siebie narzędzia. Nie potwierdziły tego jednak same służby w odpowiedziach na wnioski o informację publiczną.

Niektórzy twierdzą, że wśród wykorzystywanych przez policję i inne służby narzędzi można znaleźć takie, którymi w ogóle nie powinny się one posługiwać (mowa na przykład o opisanych wyżej koniach trojańskich, które pozwalają zdalnie przejąć kontrolę nad sprzętem komputerowym). W większości przypadków jednak to, czy korzystanie z danego narzędzia jest na miejscu, zależy od sytuacji. Tak jak założenie podsłuchu może być uzasadnione w przypadku podejrzanego o poważne przestępstwo, a niedopuszczalne prewencyjnie, tak pobranie danych o lokalizacji 1000 osób czy analiza całej komunikacji danej osoby na portalu społecznościowym w jednej sytuacji da się zaakceptować, a w innej nie.

Służby w dużej mierze wyłączone są z kontroli sprawowanej przez GIODO, a zgoda sądu wymagana jest tylko w przypadku niektórych działań, uważanych za najgłębiej ingerujące w prywatność.

Problem polega na tym, że polskie prawo nie nakreśla jasnych ram dla weryfikacji zasadności takich decyzji. Służby w dużej mierze wyłączone są z kontroli sprawowanej przez GIODO, a zgoda sądu wymagana jest tylko w przypadku niektórych działań, uważanych za najgłębiej ingerujące w prywatność. Służby twierdzą, że wystarczające są wewnętrzne mechanizmy kontroli. W CBA takim wewnętrznym hamulcem ma być specjalny pełnomocnik ds. ochrony danych (ustanowiony w odpowiedzi na wyrok Trybunału Konstytucyjnego). Policja podkreśla natomiast, że żaden funkcjonariusz nie może samodzielnie sięgnąć po dane telekomunikacyjne – potrzebuje do tego zgody przełożonego (która może jednak przyjąć formę stałego upoważnienia). Trudno uwierzyć, by te mechanizmy mogły w pełni zastąpić zewnętrzną i niezależną kontrolę.

Na ewentualne nadużycia trudno też reagować obywatelom. Powód jest prosty. O ingerencji służb w prywatność można dowiedzieć się właściwie tylko wówczas, gdy policji uda się potwierdzić związek z jakimś przestępstwem na tyle, że dojdzie do etapu procesowego i o udostępnienie danych wystąpi prokurator. Wówczas postanowienie o sięgnięciu po dane osobowe jest doręczane osobie, której dotyczy. Doręczenie może być odroczone do czasu zakończenia postępowania, jeśli jest to niezbędne ze względu na dobro sprawy. Jednak sam obowiązek poinformowania o tym nie znika. Co więcej – osobie, której postanowienie dotyczy, przysługuje prawo do zażalenia, które rozpoznaje sąd.

Jeśli służby przyglądały się czyjejś aktywności w sieci, ale nie trafiły na nic, co wskazywałoby, że ta osoba popełniła przestępstwo, prawdopodobnie nigdy się ona o tym nie dowie.

Analogicznych bezpieczników nie ma na etapie czynności operacyjnych, które z definicji są tajne. Zatem jeśli służby przyglądały się czyjejś aktywności w sieci, ale nie trafiły na nic, co wskazywałoby, że ta osoba popełniła przestępstwo, prawdopodobnie nigdy się ona o tym nie dowie.